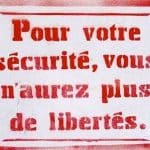

Si cette nouvelle technologie nous est présentée comme un moyen de lutter contre le fléau des morts sur la route, la réalité semble toute autre. Imposée par les institutions européennes, cette nouvelle mesure semble être une volonté bien éloignée des simples questions sécuritaires.

Surveillance et contrôles renforcés

L’intégration de la reconnaissance faciale dans les véhicules ouvre la porte à une surveillance accrue des conducteurs. En reliant cette technologie aux systèmes de contrôle routier, l’État ou les entreprises privées pourraient avoir accès à des informations précises sur les déplacements de chaque individu.

Ce système pourrait être utilisé pour :

Traquer les habitudes de conduite : Chaque fois que vous montez dans votre véhicule, vos trajets seraient potentiellement suivis, enregistrés et analysés, créant un profil de vos comportements. Cette collecte de données soulève des questions sur leur exploitation à des fins commerciales ou gouvernementales.

Amendes automatiques : Si la reconnaissance faciale est couplée à un système de contrôle automatisé des infractions, cela pourrait mener à une gestion stricte et inflexible des infractions (excès de vitesse, utilisation du téléphone, etc.). Chaque comportement répréhensible pourrait être immédiatement enregistré et sanctionné, sans intervention humaine.

Criminalisation des comportements : Certains comportements bénins ou les oublis mineurs, comme le fait de ne pas attacher sa ceinture immédiatement, pourraient entraîner des amendes automatiques, exacerbant une logique de « zéro tolérance ». Ce type de contrôle rigide limite la flexibilité des interactions humaines.

Quel impact sur vos assurances ?

L’obligation de reconnaissance faciale pourrait transformer radicalement le secteur des assurances automobiles.

En effet, cette technologie permettrait aux compagnies d’assurance d’accéder à des données très fines sur votre conduite, modifiant ainsi la manière dont les contrats sont établis et les primes calculées.

Les conséquences possibles incluent :

- Tarification en fonction du comportement : En analysant en temps réel votre manière de conduire (vitesse, vigilance, respect du code de la route), les assureurs pourraient ajuster vos primes en fonction de votre « risque » estimé. Cela créerait une forme de discrimination algorithmique, où les conducteurs seraient pénalisés financièrement pour des comportements jugés « à risque ».

- Exclusions ou restrictions de couverture : Si le système identifie des comportements dangereux ou des infractions récurrentes, l’assureur pourrait choisir de restreindre votre couverture ou même de refuser de vous assurer. Les conducteurs n’auraient plus seulement à répondre de leurs accidents, mais également de leurs habitudes quotidiennes de conduite.

- Délégitimation de la vie privée : En collectant des données personnelles, comme l’état de fatigue ou la fréquence d’utilisation du véhicule, les compagnies d’assurance pourraient évaluer des éléments qui relèvent normalement de la sphère privée. Cela soulève des questions éthiques quant à la légitimité de cette intrusion dans la vie des assurés.

Risque de dérives autoritaires

En reliant cette technologie à d’autres bases de données (étatiques, fiscales, médicales), il deviendrait possible de croiser les informations sur les citoyens, facilitant le contrôle social.

Par exemple, des citoyens déjà fichés pour des opinions dissidentes ou critiques envers le gouvernement pourraient être davantage surveillés.

Les implications politiques incluent :

- Limitation des déplacements : En cas de non-respect de certaines réglementations (impôts, comportements « déviants », etc.), les autorités pourraient restreindre ou surveiller vos déplacements. Un système pourrait être mis en place pour vous empêcher de conduire (empêcher le véhicule de démarrer) ou limiter l’accès à certaines zones.

- Répression des opinions dissidentes : Tout comme pour les réseaux sociaux, où les comportements « non conformes » peuvent entraîner des sanctions (comme la suppression de comptes), la reconnaissance faciale dans les véhicules pourrait servir à réprimer les citoyens jugés indésirables, en leur imposant des restrictions de déplacement ou en multipliant les amendes pour des infractions mineures.

Conclusion

La reconnaissance faciale obligatoire dans les véhicules neufs pose donc des problèmes majeurs en termes de libertés individuelles.

Si elle continue à évoluer, cette technologie pourrait instaurer une forme de contrôle social sur le même modèle que la Chine, et une surveillance massive, bien au-delà de la simple sécurité routière. Étant donné que les médias nous vendent cette technologie comme quelque chose de bien, permettant d’éviter des morts sur les routes, beaucoup n’y voient aucun mal et sont même d’accord.

Mais comme on a pu le voir durant la crise sanitaire, notre santé est le cadet de leurs soucis !

La reconnaissance faciale ne se limite plus à quelques caméras dans la rue. Une société de surveillance est en train de se construire sous nos yeux, avec des scans biométriques de visage dans les aéroports, les stades, les commerces, au travail et à l'école. Les Jeux Olympiques de Paris en 2024 seront également l'occasion de déployer des caméras automatisées pour surveiller les spectateurs. Mais sommes-nous prêts à vivre dans un monde où notre visage est constamment filmé, scanné et analysé ?

La reconnaissance faciale ne se limite pas à l’identification. Elle peut également être utilisée pour analyser les émotions d’une personne, pour suivre ses déplacements dans un lieu donné, ou pour établir des profils de consommation. Les possibilités sont quasi-infinies, et les entreprises privées comme les gouvernements sont de plus en plus tentés d’utiliser cette technologie pour surveiller et contrôler la population.

Le problème, c’est que la reconnaissance faciale est une menace pour notre anonymat dans l’espace public. Dans une société où notre visage est constamment filmé, scanné et analysé, il devient impossible de se fondre dans la masse et de vaquer à ses occupations sans être surveillé. Nous sommes tous potentiellement des suspects, et nos moindres faits et gestes peuvent être utilisés contre nous.

Mais des moyens de résistance existent pour préserver notre anonymat et notre vie privée. Parmi eux, le port de vêtements et d’accessoires adaptés, tels que des lunettes de soleil, des chapeaux ou des écharpes, qui permettent de dissimuler partiellement ou totalement notre visage. Des maquillages spécifiques, des tatouages ou des piercings peuvent également perturber les algorithmes de reconnaissance faciale. Enfin, des outils numériques, comme des applications ou des filtres, peuvent être utilisés pour brouiller notre image et empêcher notre identification. Ces moyens, bien que parfois contraignants ou limités, sont autant de pistes à explorer pour lutter contre la surveillance de masse et protéger nos libertés individuelles.

Yoann

0:00 Intro

1:09 Un monde de surveillance

2:28 Deepfake à 25 millions$

3:25 Comment marche la reconnaissance faciale

5:11 Facebook tagging

6:55 Moteur de recherche de visage

8:01 Clearview et Face++

9:49 Utilisation illégale de reconnaissance faciale

11:05 JO2024 & QRcodes

15:09 Chine surveillance

17:06 Visage et criminalité

21:37 Caméras NewYork

22:42 Prison panoptique

24:10 Aéroports concerts stades

27:18 Erreurs

29:19 Travail école commerces

35:04 Contrôle d'internet & id numérique

35:50 Perte de l'anonymat

37:01 Police & militaires

37:32 Résister à la reconnaissance faciale

La Russie se rapproche d’un système de surveillance extensive comparable à celui de la Chine. La région de Perm est la première à imposer aux propriétaires de caméras vidéo privées d’intégrer leurs appareils dans un réseau de surveillance régional, une pratique appelée à être reproduite à l’échelle nationale.

Cette initiative, prise par décret du gouverneur de Perm, Dmitry Makhonin, est entrée en vigueur le 25 janvier. Cette mesure s’aligne sur la déclaration de loi martiale du président Vladimir Poutine dans les territoires occupés de l’Ukraine en octobre 2022, accordant aux gouverneurs régionaux des pouvoirs accrus pour assurer la « sécurité » de leurs régions.

La surveillance des citoyens par la Russie s’est intensifiée depuis l’invasion de l’Ukraine. Les autorités scrutent de plus en plus les médias sociaux et utilisent des caméras de surveillance pour traquer les citoyens activistes. Moscou a récemment testé des feux de circulation à reconnaissance faciale. Alexander Bykov, chef de l’Inspection nationale de la sécurité routière de Moscou, a même suggéré que la fourniture de données biométriques devrait être obligatoire.

La reconnaissance faciale est un élément essentiel de la stratégie de surveillance de la Russie. Elle a été utilisée pour détenir des militants de l’opposition et pour identifier des personnes ayant ignoré des convocations à l’appel militaire, des arrestations ayant été signalées dans le métro et les gares. Sergey Suchkov, PDG de NtechLab, indique que la reconnaissance faciale est opérationnelle dans 62 régions, contribuant ainsi au projet « Data Economy » du ministère du développement numérique, qui vise à dresser un profil complet des activités des citoyens.

Actuellement, les caméras privées sont inaccessibles aux autorités régionales, et seule la moitié des 1,2 million de caméras de rue appartiennent à l’État, comme l’a indiqué le département du développement numérique en novembre 2023. L’un des principaux objectifs est de centraliser la surveillance des rues, les caméras privées jouant un rôle important.

C’est devenu une habitude. Ce mardi 14 novembre, comme ce fut le cas lors de l’édition précédente, Gérald Darmanin inaugure le salon Milipol, au parc des Expositions de Villepinte (Seine-Saint-Denis). Consacré à la sécurité intérieure des États, ce salon est une vitrine mondiale pour des entreprises souvent inconnues du grand public. C’est le cas de Briefcam, une société israélienne spécialisée dans le développement de logiciels destinés à la vidéosurveillance algorithmique (VSA). Grâce à l’intelligence artificielle, cette technologie permet d’analyser des images captées par des caméras ou des drones et de détecter des situations jugées « anormales ».

Jusqu’en mai dernier, la VSA ne pouvait être utilisée par la police nationale que dans de très rares cas. Mais à l’approche des Jeux olympiques et paralympiques de Paris, le gouvernement est parvenu à faire adopter une loi au Parlement qui autorise son expérimentation par la police nationale à une large échelle et ce, jusqu’au 31 mars 2025. Face aux risques d’atteinte à la vie privée, les députés ont néanmoins interdit le recours à la reconnaissance faciale, qui permet d’identifier une personne sur des images à partir des traits du visage. Un outil ultra-intrusif que certains logiciels commercialisés par Briefcam permettent d’activer en quelques clics. Et que les services de Gérald Darmanin connaissent bien.

Un logiciel déployé au niveau national

D’après des documents internes au ministère de l’Intérieur obtenus par Disclose, les forces de l’ordre utilisent les systèmes de Briefcam depuis 2015, dans le plus grand secret. Le logiciel en question, baptisé « Vidéo Synopsis », permet de traquer une personne sur un réseau de caméras grâce, par exemple, à la couleur de son pull. Il peut également suivre un véhicule à l’aide de sa plaque d’immatriculation ou examiner plusieurs heures de vidéos en quelques minutes. Le slogan de Briefcam, rachetée par le géant de la photo Canon en 2018 : « Transformer la vidéosurveillance en intelligence active ».

Il y a huit ans, la Direction départementale de sécurité publique (DDSP) de Seine-et-Marne est choisie pour expérimenter le logiciel israélien. Deux ans plus tard, en 2017, l’application est déployée plus largement. Les services de police du Rhône, du Nord, des Alpes-Maritimes, et de Haute-Garonne en sont à leur tour équipés. Ainsi que le service interministériel d’assistance technique (SIAT), une unité de police en charge des infiltrations, de la mise sur écoute et de la surveillance de la grande criminalité.

Dans la foulée, ce sont les services de la police judiciaire, les préfectures de police de Paris et Marseille, la sûreté publique et la gendarmerie nationale qui vont être dotés du logiciel de Briefcam sur des ordinateurs dédiés. Une installation massive qui s’est faite en dehors du cadre légal prévu par une directive européenne et la loi française Informatique et Libertés.

Avant d’utiliser une technologie aussi intrusive que celle proposée par Briefcam, le ministère de l’Intérieur aurait dû mener une « analyse d’impact relative à la protection des données » et la remettre à une administration indépendante : la Commission nationale de l’informatique et des libertés (CNIL). Or, la Direction générale de la police nationale (DGPN), placée sous l’autorité directe de Gérald Darmanin, n’avait toujours pas réalisé cette analyse d’impact en mai 2023. Pas plus qu’elle n’a averti la CNIL. Fin 2020, un cadre de la police invite ainsi à la discrétion : « Certains services ont l’outil Briefcam, mais celui-ci n’étant pas déclaré à la CNIL, il semble préférable de ne pas en parler. » Ou encore ce message envoyé quelques mois plus tard par un autre gradé, rappelant que « sur le plan juridique (…) l’application Briefcam n’a jamais été déclarée par la DGPN ».

Contactée par Disclose, la CNIL déclare, embarrassée, qu’elle « ne dispose pas d’éléments permettant d’infirmer ou de confirmer que la police nationale utilise Briefcam ». La DGPN n’a pas répondu à nos questions.

« Il semble préférable de ne pas en parler. »

Imaginez ne serait-ce que 30 secondes, un monde où toutes vos pensées, vos désirs, vos fantasmes, vos bêtises, vos écarts petits et grands seraient connus.

Imaginez un peu ceci.

Ce serait un enfer absolu.

Un monde de transparence totale serait un monde infernal.

La vie en société nécessite bien souvent une certaine forme d’hypocrisie et l’hypocrisie est d’ailleurs exigée par les normes sociales.

Imaginez un seul instant dire à tous et chacun exactement ce que vous pensez d’eux, comment vous les sentez, comment vous les jugez ?

Dans un tel monde, au bout d’une heure nous serions tous en train de nous entretuer sur fond d’insultes ou de sentiments de trahison.

Concernant les gens « dangereux ».

Estrosi veut plus de caméras et plus de reconnaissance faciale, même dans les écoles où l’on fouille désormais déjà les sacs de nos enfants d’une manière ahurissante et totalement contre-productive.

Croyez-vous un seul instant que le terroriste en Kalachnikov se masque ? Pensez-vous une seule seconde qu’une caméra va l’arrêter ?

C’est d’une naïveté confondante et confinant à la stupidité la plus totale à moins et c’est plus grave que ce soit de la manipulation basée sur des mensonges.

Et c’est évidemment cette solution hélas.

Une proposition de loi « relative à la reconnaissance biométrique dans l’espace public » est examinée en ce moment par les sénateurs.

La « loi JO », promulguée le 19 mai, autorise l’utilisation d’algorithmes pour analyser les images captées par les caméras de surveillance. C’est une première en Europe. Les ordinateurs reliés aux caméras doivent permettre, d’après leurs promoteurs, de détecter en temps réel des évènements prédéterminés, comme des mouvements de foule, un sac abandonné ou des « comportements suspects ». Avec l’appui des algorithmes, les capacités de l’État à surveiller l’espace public se voient démultipliées… à condition d’avoir des caméras qui filment !

Le 20 avril, un décret a été publié qui autorise l’utilisation des drones – équipés de caméras – par les policiers. La pratique existait déjà, on se souvient par exemple de l’utilisation de drones pendant la crise liée au Covid. Mais leur utilisation est désormais approuvée par la loi et permet aux préfets d’en faire usage de manière beaucoup plus fréquente. D’après un décompte du Monde, plus de 50 opérations de surveillance aérienne par drones ont été autorisées entre le 20 avril et le 20 mai. Manifestation écologistes, festival de Cannes, finale de la coupe de France de foot, raves parties, courses de voitures non autorisées, manifestations du 1er mai… L’État semble avoir déjà pris l’habitude de l’utilisation régulière de ces caméras volantes.

Et les drones ne sont pas les seuls à filmer. L’habitude semble également prise, côté forces de l’ordre, de filmer les manifestants depuis le sol. Celles et ceux parmi nous qui défilent régulièrement dans les grandes villes peuvent en témoigner. De manière générale, l’association La quadrature du net relève la multiplication et l’extension, « exponentielle », des moyens de captation : « caméras de vidéosurveillance fixes, caméras-piétons, caméras sur les véhicules, caméras dans les halls d’immeubles, hélicoptères de surveillance, drones de surveillance. »

De quoi s’agit-il exactement ?

Il s’agit de mettre en place des « traitements algorithmiques sur les images collectées au moyen de systèmes de vidéoprotection et de caméras installées sur des aéronefs (1) ». Si le projet de loi se défend de vouloir mettre en place de la reconnaissance faciale, il reconnaît cependant vouloir procéder, via son système de camera-protection, à un « signalement d’attention, strictement limité à l’indication du ou des événements prédéterminés qu’ils ont été programmés pour détecter ».

Faut-il s’inquiéter ou se réjouir de l’implémentation de cet outil à notre besace sécuritaire ?

De fait, depuis quelques années, chaque événement exceptionnel est prétexte à la mise en place de nouvelles mesures de contrôle qui conduisent à la construction progressive d’une société de surveillance.

Tout le monde se rappelle l’impact liberticide qu’a eu le 11 septembre 2001 sur la vie des Occidentaux. À l’époque déjà, nombreux étaient les membres de la société civile à s’inquiéter d’une dérive dont on ne voyait pas l’efficacité (les menaces terroristes n’ont pas cessé avec la mise en place de mesures de surveillance globale), et dont on ne souhaitait pas non plus la pérennité.

Ce climat a tenu pendant trente ans avec, en France, près de quarante lois contre le terrorisme. Puis il y a eu l’épisode du Covid-19 avec son cortège de passes, de QR codes, de gestion des foules par la peur et la délation, de confinements obligatoires…

Plus récemment encore, c’est avec le conflit ukrainien que le monde de la surveillance généralisée a franchi un nouveau cap. En effet, le logiciel de reconnaissance biométrique faciale américain Clearview, a été offert gratuitement aux autorités ukrainiennes afin de pouvoir identifier les soldats russes décédés sur le front et en informer leur famille dans un but de guerre psychologique.

Une autre excuse pour introduire l’identification numérique.

Après avoir créé une technologie – utilisée pendant des années, voire des décennies dans l’industrie du divertissement – pour produire des contrefaçons profondes, pourquoi cette même industrie ne nous mettrait-elle pas en garde contre tous les dangers de cette technologie – et ne proposerait-elle pas de toutes nouvelles solutions à ce problème, que certaines d’entre elles auraient ostensiblement créées en premier lieu ?

Il pourrait y avoir un public pour cela.

En particulier celui qui croit à l’idée que la plupart des gens, de nos jours, « vivent leur vie en ligne » – ce qui n’est pas vrai, en ce qui concerne la plupart des gens. Certes, les services en ligne tels que la banque et le chat sont pratiques, mais « vivre » une vie en ligne est une proposition tout à fait différente.

Ensuite, il y a le terme « intelligence artificielle » (IA), alors que toute personne ayant une connaissance, même superficielle, de cette technologie sait que nous sommes aujourd’hui TRÈS loin de ce que les médias grand public font croire, ou de ce qu’ils sont susceptibles de réaliser (le mieux que l' »IA » puisse offrir aujourd’hui est un faible sous-ensemble appelé « apprentissage automatique », ML).

Cela mis à part, le Times of London semble vous demander de mettre de côté toutes vos connaissances, votre scepticisme et votre expérience, et de suivre l’histoire – comme dans « ne jamais laisser la vérité se mettre en travers d’une bonne histoire ».

C’est ainsi que nous apprenons que des « entrepreneurs inventent des défenses d’identité numérique ».

L'un de leurs systèmes les plus connus est Face++, qui est utilisé par la police pour retrouver des criminels. Cependant, cette technologie peut également être utilisée de manière beaucoup plus intrusive, à des fins de surveillance de masse, de violation de la vie privée et de discrimination. De plus, les systèmes de reconnaissance faciale ne sont pas infaillibles et peuvent parfois donner des résultats erronés, ce qui peut entraîner des conséquences graves pour les individus concernés.

Le projet Skynet est un système de surveillance et de sécurité national de la Chine qui utilise des technologies avancées telles que la reconnaissance faciale, l’analyse des comportements et des données de masse pour surveiller la population du pays. Le système comprend un vaste réseau de caméras de sécurité, des bases de données de surveillance, des centres de surveillance et de contrôle et des logiciels d’analyse avancés. Sous couvert d’être utilisé pour lutter contre le crime, il a été critiqué pour ses violations de la vie privée et pour le potentiel de surveillance et de contrôle de masse qu’il représente.

Visa, le partenaire officiel de la FIFA en matière de technologies de paiement, est prêt à apporter ce qu’il appelle des technologies de paiement biométriques « innovantes » à la Coupe du monde au Qatar, qui débute dimanche. Plus d’un million de fans de football sont attendus au Qatar pour le tournoi quadriennal.

Visa a installé 5 300 terminaux de paiement sans contact sur les sites de la FIFA, faisant de la Coupe du monde du Qatar le tournoi le plus équipé en moyens de paiement organisé par la FIFA. La Coupe du monde offre à Visa une scène mondiale pour tester de nouvelles technologies. Au Qatar, Visa mènera plusieurs projets pilotes limités qui illustrent l’avenir des paiements.

L’émission présentera du contenu drôle et viral capturé par les caméras Ring, comme « des voisins qui sauvent leurs voisins, des demandes en mariage, des réunions militaires et des animaux stupides ».

De telles vidéos peuvent être divertissantes et deviennent souvent virales. Cependant, elles détournent l’attention des gens de la surveillance de masse exercée par les caméras Ring. Les vidéos des caméras Ring ont été utilisées dans le cadre d’enquêtes menées par les forces de l’ordre aux États-Unis et à l’étranger, allant jusqu’à tirer des vidéos des caméras de sonnettes des particuliers sans mandat.

En entretenant la peur de la criminalité dans les banlieues et en s’associant avec les services de police, Amazon a déployé de manière agressive les caméras de surveillance domestique Ring.

Vers une surveillance totale de vos déplacements ?

Vers une surveillance totale de vos déplacements ?

Votre visage nous appartient !

Votre visage nous appartient !

Russie : Une intensification de la suppression de la vie privée

Russie : Une intensification de la suppression de la vie privée

La police utilise illégalement un logiciel israélien de reconnaissance faciale

La police utilise illégalement un logiciel israélien de reconnaissance faciale

Estrosi « La première des libertés c’est la reconnaissance faciale »

Estrosi « La première des libertés c’est la reconnaissance faciale »

Règlement CSAR : la surveillance de nos communications se joue maintenant à Bruxelles

Règlement CSAR : la surveillance de nos communications se joue maintenant à Bruxelles

Reconnaissance faciale : la grande accélération

Reconnaissance faciale : la grande accélération

Les Jeux Olympiques: cheval de Troie de la société de surveillance ?

Les Jeux Olympiques: cheval de Troie de la société de surveillance ?

Le Projet Skynet : La vaste surveillance chinoise qui inquiète le monde

Le Projet Skynet : La vaste surveillance chinoise qui inquiète le monde

Coupe du monde au Qatar : terrain d’essai pour le paiement par face

Coupe du monde au Qatar : terrain d’essai pour le paiement par face