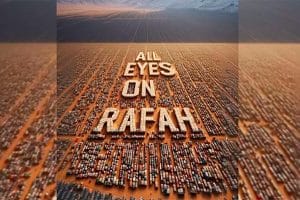

Le slogan "All eyes on Rafah" est employé par les manifestants dénonçant les massacres qui se répètent à Gaza depuis dix mois. Il prend aujourd’hui un autre sens : celui de la surveillance militaire absolue des Palestiniens avec les moyens de Google, Microsoft et Amazon, désormais au service d’une "usine d’assassinats de masse".

Le "panoptique" de Jeremy Bentham, rendu célèbre par Michel Foucault, est l’un des "passages obligés" dès que l’on s’intéresse aux questions de la surveillance ou du numérique, qui sont désormais peu ou prou la même chose. On parle de "société de surveillance", de "capitalisme de surveillance", et l’on cite donc Surveiller et Punir.

De là, l'effet majeur du Panoptique : induire chez le détenu un état conscient et permanent de visibilité qui assure le fonctionnement automatique du pouvoir. Faire que la surveillance soit permanente dans ses effets, même si elle est discontinue dans son action ; que la perfection du pouvoir tende à rendre inutile l'actualité de son exercice ; que cet appareil architectural soit une machine à créer et à soutenir un rapport de pouvoir indépendant de celui qui l'exerce ; bref que les détenus soient pris dans une situation de pouvoir dont ils sont eux-mêmes les porteurs. Pour cela, c'est à la fois trop et trop peu que le prisonnier soit sans cesse observé par un surveillant : trop peu, car l'essentiel c'est qu'il se sache surveillé ; trop, parce qu'il n'a pas besoin de l'être effectivement. [1]

Gaza correspond aujourd’hui, assez littéralement, à une prison sous surveillance pan-optique : avec des yeux qui voient tout, partout, tout le temps. Avec un élément supplémentaire : cette surveillance qui emploie les outils des plus grandes entreprises américaines du numérique, sert à pointer les cibles qui sont ensuite bombardées. Si vous lisez l’actualité, vous savez que l’armée israélienne (Tsahal) a bombardé des camps de réfugiés [2], des hôpitaux [3], des écoles [4], des zones dites "sûres" [5], des journalistes [6] et des travailleurs humanitaires [7].

La guerre "propre"

Il faut d’abord que je vous parle rapidement de Yuval Abraham, que l’on connaît surtout en France pour une polémique lors du festival de cinéma de Berlin de 2024. Co-réalisateur avec Basel Adra du documentaire "No other land", il avait déclaré, au moment de recevoir le prix du meilleur documentaire : "Basel et moi avons le même âge. Je suis Israélien, il est Palestinien. Dans deux jours, nous retournerons sur une terre où nous ne sommes pas égaux : je vis sous une loi civile, Basel est soumis à une loi militaire. Nous habitons à trente minutes l’un de l’autre, mais j’ai le droit de vote, Basel ne l’a pas. Je peux me déplacer librement sur cette terre. Basel, comme des millions de Palestiniens, est bloqué dans la Cisjordanie occupée. Cette situation d’apartheid entre nous, cette inégalité, doit cesser". [8]

Pour ce discours, Yuval Abraham a été menacé de mort en Israël, mais également critiqué par la classe politique allemande, dont le maire de Berlin : "L'antisémitisme n'a pas de place à Berlin, et cela vaut aussi pour les artistes", a dénoncé le maire de la capitale allemande, Kai Wegner, sur son compte X (ex-Twitter). "Ce qui s'est déroulé (dimanche) à la Berlinale a constitué une relativisation insupportable", a-t-il ajouté. [9]

Pourtant, Abraham sait de quoi il parle. C’est à lui que l’on doit un premier article dans la revue +972, en novembre 2023, qui révèle pour la première fois l’existence d’un logiciel d’IA employé par Tsahal à Gaza : "Un ancien officier du renseignement explique que le système Habsora permet à l’armée de mettre en place une « usine d’assassinats de masse » dans laquelle on met l’accent sur la quantité et non la qualité. Un humain « jettera un œil » aux cibles avant chaque attaque, mais il n’a pas besoin d’y consacrer énormément de temps. Puisqu’Israël estime qu’il y a environ 30 000 membres du Hamas à Gaza, et qu’ils sont tous marqués pour être tués, le nombre de cibles potentielles est énorme." [10]

Car les dispositifs techniques déployés par l’armée israélienne sont pléthore. C’est que la sophistication des moyens de tuer sert d’abord à justifier la guerre que l’on fait, prétextant que les uns tuent comme des barbares, les autres comme des êtres civilisés, moraux, respectueux de leurs victimes.

Dont acte : en France, les plateaux-télé ont fourmillé de commentateurs expliquant que les morts israéliens du 7 octobre, et ceux, palestiniens, qui s’en sont suivis, ça n’était pas pareil. Raphaël Enthoven dit sur BFMTV le 10 octobre 2023 : "Il y a une différence à faire entre des gens qui sont des civils, qui sont assassinés dans la rue par des commandos islamistes et les victimes collatérales de bombardements consécutifs à cette attaque. Il faut marquer cette différence, c'est même très important de la faire." [11]

Caroline Fourest reprend en écho le 29 octobre: "On ne peut pas comparer le fait d'avoir tué des enfants délibérément comme le Hamas, et le fait de les tuer involontairement comme Israël" [12] . Elle insiste encore le lendemain : "Je maintiens, malgré la meute, qu’il existe une différence d’intention fondamentale entre cibler des enfants pour les décapiter et perdre la tête au point de bombarder le Hamas au milieu d’enfants." [13]

François Hollande, désormais député PS, bafouillait en répondant aux questions qui lui étaient posée sur France Info le 7 février 2024 : "Puisqu’on a parlé de l’hommage rendu aux victimes françaises en Israël lors de l’attaque du 7 octobre, est-ce qu’il faudra rendre un même hommage aux victimes à Gaza ?

Bien entendu, cette proposition, ça ne peut pas être le même hommage. Une vie est une vie, et une vie est équivalente à une autre vie. Mais il y a les victimes du terrorisme et il y a les victimes de guerre. […] Les victimes collatérales, vous êtes dans une guerre, vous êtes une victime collatérale, il y en a en Ukraine. [14]

Enfin, Céline Pina, le 6 novembre 2023 sur Cnews est celle qui l’exprime le plus clairement : "Une bombe qui explose et qui va détruire et qui va faire des dégâts collatéraux tuera sans doute des enfants. Mais ces enfants ne mourront pas en ayant l’impression que l’humanité a trahi tout ce qu’ils étaient en droit d’attendre. Là ce qui est horrible, c’est d’imaginer ces enfants qui avaient 8, 9, 10 ans, ces femmes qui sont parties en emportant comme dernière image, une image d’inhumanité, d’atrocité et de mépris de ce qu’ils sont. C’est là où se niche le crime contre l’humanité, la négation absolue. Je pense qu’on aurait intérêt à l’expliquer beaucoup plus parce que sinon le règne de l’émotion met des signes "égal" entre toutes les victimes. Or c’est vrai, un mort Palestinien, un mort Israélien, ça reste deux morts, mais la manière dont ils ont été tués, elle, elle parle de notre inhumanité ou de notre humanité. [15]

Ces déclarations sont à comparer aux témoignages du personnel soignant revenu de Gaza. Citons par exemple le chirurgien Feroze Sidhwa, qui était à l’hôpital de Khan Younis entre le 25 mars et le 8 avril :

A quel point-est-ce difficile pour les enfants qui sont là-bas ?

"Il y a plusieurs aspects à cela. Mais l’un d’eux est la manière dont ces enfants sont morts. La plupart ont été tués dans des explosions où beaucoup d’entre eux se sont probablement retrouvés piégés dans les décombres. Certains vont mourir immédiatement d’un bloc de béton qui leur tombe sur la tête, ou quelque chose de ce genre. Mais beaucoup d’entre eux se retrouvent la jambe coincée dans les gravats, et comme il n’y a pas de machinerie lourde, il n’y a aucun moyen d’aller les chercher ; ils meurent lentement de septicémie alors qu’ils sont enterrés dans ces tombes obscures, seules, gelés pendant la nuit, brûlant pendant la journée. Et ça doit prendre des jours pour chacun d’eux. Trois, quatre, cinq jours pour qu’ils meurent de cette façon. C’est horrible de penser à l’ampleur de leur souffrance." [16]

La rhétorique de la "guerre propre" a déjà été mise en évidence par Grégoire Chamayou dans son livre Théorie du Drone, dans lequel il raconte ce phénomène de distanciation et ses effets sur la doctrine militaire.

"Le drone chasseur-tueur, prétendent ses partisans, représente un « progrès majeur dans la technologie humanitaire ». Par là, ils ne veulent pas dire que cet engin pourrait par exemple servir à acheminer des vivres ou des médicaments dans des zones dévastées. Ils veulent dire tout autre chose : que le drone est humanitaire en tant qu’arme, en tant que moyen de tuer." […]

"Les armées modernes utilisant déjà des logiciels d’aide à la décision censés assurer leur meilleure adéquation aux exigences du droit de la guerre – et, par là, les rendre plus « éthiques » –, on peut se faire une petite idée de la façon dont peuvent, en pratique, se fixer les valeurs pertinentes : aux premiers jours de l’invasion en Irak, ils ont fait tourner des logiciels. Ils ont appelé ça le programme « moucheron écrasé » [bugsplat]. Ce programme informatique estimait le nombre de civils qui seraient tués dans un raid aérien donné. Les résultats présentés au général Tommy Franks indiquaient que vingt-deux des bombardements aériens prévus allaient entraîner ce qu’ils avaient défini comme étant un fort taux de moucherons écrasés – soit plus de trente civils tués par attaque. Franks dit : « allez-y, les gars, on les fait tous les vingt-deux »." [17]

La "guerre propre" est une rhétorique de déculpabilisation et de déresponsabilisation, car on "minimise le nombre de victimes collatérales". C’est tout l’inverse en réalité : les systèmes de surveillance et de ciblage de masse sont utilisés de manière totalement indiscriminée. Au lieu de tuer "moins et mieux", ces dispositifs techniques produisent l'effet inverse.

Surveiller, cibler, bombarder

C’est ce que montre un deuxième article de Yuval Abraham, en avril 2024, révélant l’existence de deux autres systèmes d’IA, "Lavender" et "Where’s Daddy" : "Lavender a joué un rôle central dans les bombardements inédits des Palestiniens, en particulier au début de la guerre. D’après nos sources, son influence sur les opérations militaires était telle que les résultats de la machine d’IA étaient traités « comme si c’était une décision humaine »." […]

"Selon deux de ces sources, l’armée a également fait le choix inédit pendant les premières semaines de la guerre d’autoriser à tuer, pour tout agent subalterne du Hamas marqué par Lavender, jusqu’à 15 ou 20 civils ; par le passé, l’armée n’autorisait aucun "dégât collatéral" pour les assassinats de militants en bas de la hiérarchie. Les sources précisent que, dans l’éventualité où la cible serait un haut-gradé du Hamas, un commandant de bataillon ou de brigade, l’armée a autorisé à plusieurs reprises l’assassinat de plus de 100 civils pour l’assassinat d’un seul commandant." […]

"Afin d’assassiner Ayman Nofal, le commandant de la Brigade Central de Gaza du Hamas, une source affirme que l’armée a autorisé le meurtre d’environ 300 civils, détruisant plusieurs bâtiments dans le camp de réfugiés d’Al-Bureij le 17 octobre, en se basant sur une géolocalisation peu précise de Nofal. Les images satellitaires et les vidéos sur place montrent que plusieurs grands immeubles résidentiels à plusieurs étages ont été détruits." [18]

Cette doctrine de bombardement, non pas aveugle, mais au contraire quasi omnisciente est donc à l’origine de "la mort de 15 000 Palestiniens — presque la moitié du décompte jusqu’à présent [en Avril] — dans les six premières semaines de la guerre". Ces méthodes sont rendues possibles par deux choses : la première, une surveillance de masse de tous les instants. La seconde, qui est son corollaire, la collecte et l’emploi de masses de données sans précédent.

Le journaliste Antony Loewenstein (que j’ai interviewé en novembre ici) l’a expliqué en détail dans son livre, The Palestine laboratory, publié en 2023. La totalité du livre pourrait servir d’exemple. Je n’en citerai qu’un extrait : "L’ IDF [Israeli Defense Forces] utilise la reconnaissance faciale à grande échelle avec un nombre croissant de caméras et de téléphones portables afin de ficher chaque Palestinien en Cisjordanie. À partir de 2019, les soldats israéliens se servent de l’application Blue Wolf pour prendre les visages des Palestiniens en photo, qui étaient ensuite comparés à une base de données gigantesque, surnommée « le Facebook des Palestiniens ». Les soldats étaient mis en compétition pour prendre le plus grand nombre de photos de Palestiniens et les plus prolifiques gagnaient des prix."

"Le système est particulièrement extrême dans la ville d’Hebron, où la reconnaisance faciale et de nombreuses caméras sont employées pour surveiller les Palestiniens, parfois même dans leurs foyers, contrairement aux colons juifs qui habitent là et lancent des menaces génocidaires envers les Palestiniens avec régularité. L’IDF affirme que ce programme était conçu pour « améliorer la qualité de vie » de la population palestinienne."

Ce que corrobore le témoignage d’un ancien soldat de Tsahal en poste à Hébron, rapporté par l’ONG Breaking the Silence en 2020 : "On sort avec Blue Wolf (un système de détection biométrique et de fichage) avec pour objectif : collecter dix visages, collecter dix correspondances avec Blue Wolf."

[...]

Surveillance militaire absolue au service d’une "usine d’assassinats de masse"

Surveillance militaire absolue au service d’une "usine d’assassinats de masse"